Algorithmisch Rekursive Sequenzanalyse |

|

ARS entschlüsselt generative Regeln von Sprachsequenzen, kombiniert qualitative Strukturanalyse mit probabilistischer Modellierung und liefert erklärbare Ergebnisse. Es geht über rein deskriptive Ansätze hinaus und setzt sich bewusst von opaken KI-Systemen ab. Noch unbemerkt von der Scientific Community, deutet ARS auf die Zukunft qualitativer Forschung hin: transparent, hybrid und interdisziplinär. ARS uncovers generative rules of language sequences, combining qualitative structural analysis with probabilistic modeling to deliver explainable results. It goes beyond purely descriptive approaches and deliberately distinguishes itself from opaque AI systems. Still unnoticed by the scientific community, ARS points to the future of qualitative research: transparent, hybrid, and interdisciplinary. Mehr auf the-last-freedom.org Sequenzanalyse Sequence Analysis

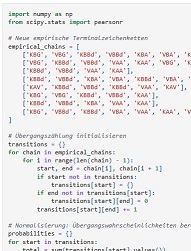

Die Algorithmisch-Rekursive Sequenzanalyse entschlüsselt generative Regeln natürlicher Sprachsequenzen. Basierend auf empirischen Daten induziert sie probabilistische Grammatiken und integriert qualitative Strukturanalyse mit robuster statistischer Validierung. Als erklärendes Modell überwindet ARS 2.0 die Grenzen rein deskriptiver Ansätze und opaker KI-Systeme und bietet tiefere Einblicke für Sozial-, Linguistik- und Informatikforschung. Algorithmic Recursive Sequence Analysis deciphers generative rules in natural language sequences. Based on empirical data, it induces probabilistic grammars and integrates qualitative structural analysis with robust statistical validation. As an explanatory model, ARS 2.0 transcends the limitations of purely descriptive approaches and opaque AI systems, offering deeper insights for social, linguistic, and computer science research. Grammatikinduktion Grammar Induction

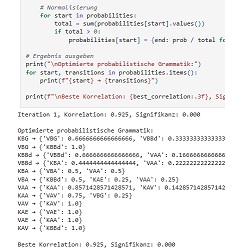

Grammatikwahrscheinlichkeiten werden schrittweise optimiert. Statistische Methoden wie Spearman-Korrelationen und Signifikanzanalysen dienen dabei der präzisen Anpassung und Validierung des Modells. Grammar probabilities are iteratively optimized. Statistical methods like Spearman correlations and significance analyses are used for precise model adjustment and validation. Grammatikoptimierung Grammar Optimization

Die Grammatikwahrscheinlichkeiten erfahren eine iterative Verfeinerung. Mithilfe von Spearman-Korrelationen und Signifikanztests wird die Modellleistung statistisch evaluiert und kontinuierlich optimiert. Grammar probabilities undergo iterative refinement. Spearman correlations and significance tests statistically evaluate and continuously optimize model performance. |