Algorithmisch Rekursive Sequenzanalyse |

|

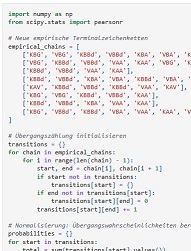

Die qualitative Sozialforschung steht gegenwärtig vor einem Paradoxon: Einerseits versprechen generative KI-Systeme eine enorme Skalierung interpretativer Arbeitsschritte, andererseits entziehen sie sich durch ihre stochastische Natur der klassischen Validierung. Wo früher die detaillierte Offenlegung des Codierprozesses und die intersubjektive Nachvollziehbarkeit im Zentrum standen, tritt heute oft ein blinder Verlass auf die "Emergenz" neuronaler Netze. Dieser Trend ignoriert jedoch, daß die computergestützte Textanalyse eine lange Tradition besitzt, die weit vor dem aktuellen Deep-Learning-Paradigma ansetzte und auf expliziten regelbasierten Logiken fußte. Während opake Large Language Modelle zunehmend in der qualitativen Forschung Verwendung finden, blieb der Kognitivismus, der einst die Möglichkeit einer formalisierten Sinnmodellierung bot, weitgehend unbeachtet. Gerade diese formalisierenden Ansätze - sei es in Scheme, Lisp, R oder Python - erlauben es, Interpretationsprozesse transparent und reproduzierbar zu modellieren. Möglich ist dies etwa durch den Einsatz von Petri-Netzen zur Prozessrekonstruktion, Bayesschen Netzen zur Kausalmodellierung oder kontextfreien probabilistischen Grammatiken zur Erfassung latenter Sinnstrukturen. Solche XAI-inspirierten Verfahren könnten eine Brücke schlagen zwischen der interpretativen Offenheit qualitativer Forschung und der erklärenden Strukturiertheit algorithmischer Modelle - und so die Opazität gegenwärtiger LLM-Ansätze produktiv unterlaufen. Qualitative social research is currently facing a paradox: on the one hand, generative AI systems promise an enormous scaling of interpretative work steps, on the other hand, they elude classical validation due to their stochastic nature. Where in the past the detailed disclosure of the coding process and intersubjective traceability were the focus, today there is often blind reliance on the "emergence" of neural networks. However, this trend ignores the fact that computer-aided text analysis has a long tradition that predates the current deep learning paradigm and was based on explicit rule-based logic. While opaque large language models are increasingly being used in qualitative research, cognitivism, which once offered the possibility of formalized meaning modeling, has largely gone unnoticed. It is precisely these formalizing approaches - be it in Scheme, Lisp, R or Python - that make it possible to model interpretation processes in a transparent and reproducible way. This is possible, for example, through the use of Petri networks for process reconstruction, Bayesian networks for causal modelling or context-free probabilistic grammars for the capture of latent meaning structures. Such XAI-inspired methods could build a bridge between the interpretative openness of qualitative research and the explanatory structure of algorithmic models - and thus productively undermine the opacity of current LLM approaches. Mehr auf the-last-freedom.org Sequenzanalyse Sequence Analysis

Die Algorithmisch-Rekursive Sequenzanalyse entschlüsselt generative Regeln natürlicher Sprachsequenzen. Basierend auf empirischen Daten induziert sie probabilistische Grammatiken und integriert qualitative Strukturanalyse mit robuster statistischer Validierung. Als erklärendes Modell überwindet ARS 2.0 die Grenzen rein deskriptiver Ansätze und opaker KI-Systeme und bietet tiefere Einblicke für Sozial-, Linguistik- und Informatikforschung. Algorithmic Recursive Sequence Analysis deciphers generative rules in natural language sequences. Based on empirical data, it induces probabilistic grammars and integrates qualitative structural analysis with robust statistical validation. As an explanatory model, ARS 2.0 transcends the limitations of purely descriptive approaches and opaque AI systems, offering deeper insights for social, linguistic, and computer science research. Grammatikinduktion Grammar Induction

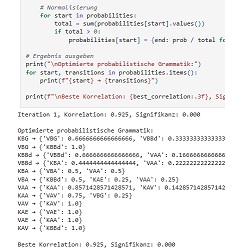

Grammatikwahrscheinlichkeiten werden schrittweise optimiert. Statistische Methoden wie Spearman-Korrelationen und Signifikanzanalysen dienen dabei der präzisen Anpassung und Validierung des Modells. Grammar probabilities are iteratively optimized. Statistical methods like Spearman correlations and significance analyses are used for precise model adjustment and validation. Grammatikoptimierung Grammar Optimization

Die Grammatikwahrscheinlichkeiten erfahren eine iterative Verfeinerung. Mithilfe von Spearman-Korrelationen und Signifikanztests wird die Modellleistung statistisch evaluiert und kontinuierlich optimiert. Grammar probabilities undergo iterative refinement. Spearman correlations and significance tests statistically evaluate and continuously optimize model performance. |